Mit ChatGPT Pulse erweitert OpenAI seine Produktstrategie um ein Feature, das Nutzer nicht nur auf Anfrage informiert, sondern proaktiv personalisierte Inhalte bereitstellt.

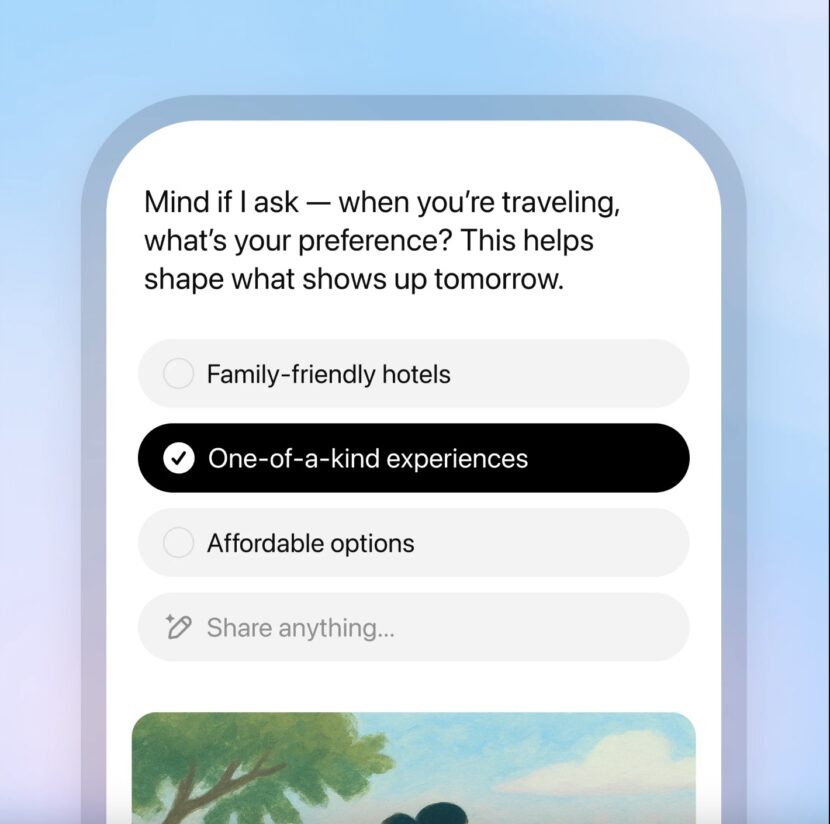

ChatGPT stellt sein neues Produkt “Pulse” für Pro-Nutzer vor. Statt Antworten auf konkrete Prompts zu liefern, analysiert Pulse bestehende Chatverläufe, Nutzersignale und optional auch externe Datenquellen wie Google Kalender oder Gmail, um täglich automatisiert kuratierte Informationskarten bereitzustellen.

Inhalt

Funktionen und Einsatzweise

Pulse führt einen Paradigmenwechsel ein: von der reaktiven hin zur proaktiven KI. Die Anwendung soll:

- Themen aufgreifen, die in vorherigen Konversationen relevant waren

- kontextbezogene Empfehlungen generieren (z. B. Reisevorschläge, Meeting-Agenden, Rezeptideen)

- auf Wunsch spezifische Inhalte liefern, die Nutzer aktiv anfordern (z. B. Veranstaltungstipps für Freitag)

- durch einfache Feedbackmechanismen (z. B. Daumen hoch/runter) fortlaufend “lernen”, was relevant ist

Dazu kommen optische Kurzkarten, die sich täglich aktualisieren und bei Bedarf in tiefere Inhalte verzweigen lassen. Integrationen mit Drittanbietern sind optional und deaktivierbar.

Technische und konzeptionelle Grenzen

Trotz aller Automatisierung bleibt Pulse in zentralen Punkten fehleranfällig:

INSERT_STEADY_NEWSLETTER_SIGNUP_HERE

- Die Ergebnisse beruhen nicht auf verifizierter Recherche, sondern auf statistischen Schätzungen, was „relevant“ sein könnte

- Inhalte können veraltet oder kontextuell unpassend sein (z. B. Tipps zu bereits abgeschlossenen Projekten)

- Die Qualität hängt maßgeblich vom vorherigen Nutzungsverhalten ab und kann durch Missverständnisse oder unvollständige Datenlage deutlich abfallen

- Es besteht keine Garantie für inhaltliche Richtigkeit oder Vollständigkeit

OpenAI weist bereits zur Einführung ausdrücklich darauf hin, dass Pulse „nicht immer richtig liegt“. Diese Einschränkung ist nicht nur ein Problem der Beta-Phase, sondern Ausdruck struktureller Schwächen generativer KI-Systeme insgesamt. Welches andere Produkt wird mit dem Hinweise eingeführt, dass es fehlerhaft ist?

Dass OpenAI sich hier absichern muss, zeigt das grundlegende Dilemma generativer KI: Diese Systeme erzeugen Inhalte, ohne deren Wahrheitsgehalt sicherstellen zu können. Das liegt nicht an unvollständigen Trainingsdaten, sondern an der Architektur selbst. Generative Sprachmodelle berechnen Wahrscheinlichkeiten für sinnvolle Textfolgen, ohne Kontext wirklich zu „verstehen“ oder zwischen Fakten und Fiktion unterscheiden zu können.

Sie möchten eine kurze Einschätzung zur SEO-Performance Ihrer Website?

Schreiben Sie mich einfach an und nennen Sie mir die aktuellen Herausforderungen.

Grundsätzlich problematisches Modell

Pulse ist kein Einzelfall, sondern ein Symptom für ein größeres Problem: Das Versprechen, KI könne Entscheidungen vorbereiten, Handlungen vorstrukturieren oder unseren Alltag „automatisiert“ verbessern, basiert auf einer Illusion maschinischer Kompetenz und ist letztlich nicht mehr als ein PR-Versprechen, das bisher nie eingelöst wurde.

Viele Unternehmen, die in der Vergangenheit Jobs an KI ausgelagert haben, suchen nun händeringend wieder Personal, weil sie feststellen, dass diese KI extrem fehleranfällig und keinesfalls sicher ist.

Das Geschäftsmodell, das eine hohe Fehlerquote mit einpreist und das Problem den eigenen Kunden überlässt ist hochproblematisch. Nutzer sollen ein Produkt abonnieren, das weder Transparenz über seine Quellen noch Gewährleistung für die Qualität seiner Empfehlungen bieten kann. Es geht dabei nicht um vereinzelte Fehlfunktionen, sondern um systemische Unsicherheit. In sicherheitsrelevanten oder sensiblen Bereichen (z. B. Gesundheit, Finanzen, Bildung) ist der Einsatz solcher Technologien potenziell schädlich.

Solange sich an der zugrundeliegenden Modellarchitektur nichts ändert, wird es keine Lösung für dieses Grundproblem geben. Die Fähigkeit zur Sprache wird mit der Fähigkeit zur Erkenntnis verwechselt, ein Fehler, der durch Pulse weiter normalisiert wird.

Pulse soll vor allem die Abhängigkeit von der Plattform steigern

Pulse ist kein funktionales Zusatzfeature, sondern in erster Linie ein strategisches Instrument zur Plattformbindung. Ziel ist es, Nutzende täglich in die Anwendung zurückzuholen, eine langfristige Verhaltensgewohnheit aufzubauen und damit ein anhaltendes Interaktionsmuster zu etablieren. Die Funktionsweise ähnelt dem Prinzip von Social-Media-Feeds, ist aber enger in die individuelle Nutzung eingebettet unter dem Vorwand personalisierter Assistenz.

Diese Strategie ist nicht neu. Plattformen wie Google, Meta oder TikTok arbeiten seit Jahren mit Methoden zur Nutzerbindung über tägliche Updates, Empfehlungen oder Push-Content. OpenAI adaptiert dieses Modell für generative KI mit einem entscheidenden Unterschied: Es geht nicht mehr nur um Inhalte aus der Außenwelt, sondern um synthetisch erzeugte Vorschläge, basierend auf persönlichen Daten und Chatverläufen.

Pulse ist damit ein erster Schritt zu einer KI-zentrierten Plattformlogik, in der alle Interaktionen über eine KI-Schnittstelle laufen sei es zur Information, Planung, Unterhaltung oder Kommunikation. Wer täglich mit Pulse „arbeitet“, trainiert zugleich ein Modell, das ihn besser kennt als jede klassische Plattform zuvor, ohne dass klar ist, wo diese Daten gespeichert, verwendet oder verknüpft werden.

Für die Plattform bedeutet das: Je mehr Interaktionen in ChatGPT stattfinden, desto weniger verbleiben in klassischen Ökosystemen wie Google Search, Instagram oder WhatsApp. Für die Nutzenden bedeutet es: Je mehr Abhängigkeit von einem KI-gesteuerten System entsteht, desto schwerer wird es, sich dieser Logik zu entziehen oder die Kontrolle über eigene Daten und Entscheidungen zu behalten.

Diese strategische Perspektive macht deutlich: Pulse ist kein harmloses Assistenztool, sondern ein ökonomischer Hebel zur Verlagerung von Aufmerksamkeit, Daten und Marktanteilen. Die Risiken für Transparenz, Datenschutz und digitale Autonomie sind entsprechend weitreichend.

Udo Raaf (Geschäftsführer)

Udo Raaf ist Publisher und SEO-Berater mit über 15 Jahren Erfahrung in der strategischen Suchmaschinenoptimierung für Unternehmen, Agenturen und gemeinnützige Organisationen.

Sie möchten wissen, welches Potenzial in Ihrer Website steckt?

Füllen Sie den nachfolgenden Fragebogen aus für eine unverbindliche Ersteinschätzung Ihres Projekts. Ich arbeite mit einem erstklassigen Netzwerk aus Web-Entwicklern, KI-Experten und Autoren zusammen, um maßgeschneiderte Lösungen anzubieten.