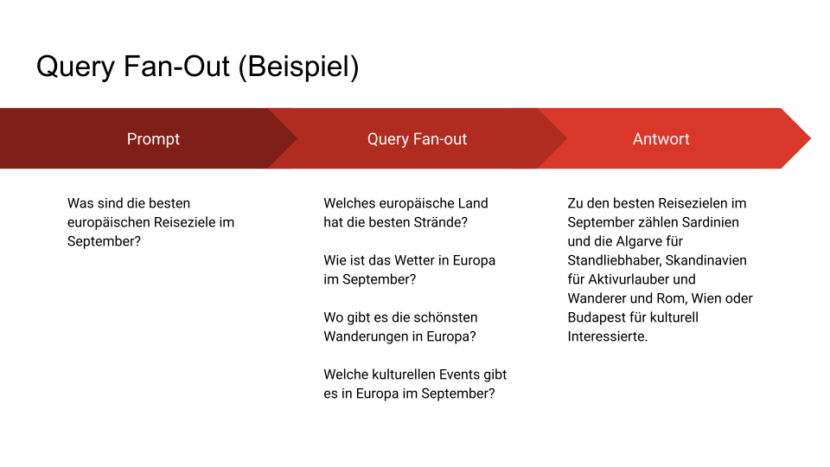

Query Fan-Out bezeichnet ein Verfahren in KI-basierten Suchsystemen, bei dem eine Nutzeranfrage in mehrere Teilanfragen (Subqueries) aufgespalten wird.

Diese parallelen Suchprozesse ermöglichen es, verschiedene Aspekte der ursprünglichen Frage gleichzeitig zu bearbeiten und die Ergebnisse zu einer kohärenten Antwort zusammenzuführen. Wörtlich bedeutet der Begriff so viel wie „Verzweigung der Abfrage“ – gemeint ist die automatische Zerlegung komplexer oder mehrdeutiger Suchanfragen in strukturierte Einzelfragen.

Das Verfahren kommt insbesondere in modernen Systemen wie Google AI Mode, ChatGPT oder Perplexity zum Einsatz.

Beispiel 1: Komplexe Rechercheaufgaben

Eine klassische Suchmaschine würde bei einer Anfrage wie

„Was ist der Unterschied zwischen OpenAI, Anthropic und Mistral im Hinblick auf Datensicherheit?“ zehn blaue Links liefern, idealerweise zu Fachartikeln, häufig aber auch zu einzelnen Unternehmensseiten, Wikipedia oder irrelevanten Ergebnissen.

Ein KI-System mit Query Fan-Out geht anders vor und spart den Nutzern dadurch mehrere Klicks, um die richtige Antwort zu finden. Die Anfrage wird automatisch aufgeteilt in mehrere Teilfragen wie:

INSERT_STEADY_NEWSLETTER_SIGNUP_HERE

- „Wie geht OpenAI mit Nutzerdaten um?“

- „Welche Datenschutzrichtlinien hat Anthropic?“

- „Wie speichert Mistral Nutzereingaben?“

- „Gibt es Vergleiche zwischen diesen Anbietern?“

Die KI ruft gezielt Inhalte zu diesen Einzelaspekten aus den Trainingsdaten oder dem Web ab, extrahiert relevante Passagen, gewichtet sie, stellt Unterschiede heraus und formuliert eine strukturierte, vergleichende Antwort. Und all das in Sekundenschnelle. Die Antwort erscheint wie aus einem Guss, basiert aber auf einer Vielzahl gezielter Abfragen, die im Hintergrund ausgeführt wurden.

Wichtig: Ob die Antwort korrekt ist, muss immer überprüft werden. Fehler oder Unsicherheiten in den Trainingsdaten, den Quellen oder bei der Gewichtung kann eine KI nicht bewerten, die abschließende Bewertung liegt also immer beim Nutzer selbst und das erfordert eine hohe Fachkenntnis und weitere Recherchen, um die Antwort zu verifizieren.

Beispiel 2: Uneindeutige Intentionen

Ein Nutzer stellt die Frage:

„Was ist das beste CRM-System für Startups?“

Sie möchten eine kurze Einschätzung zur SEO-Performance Ihrer Website?

Schreiben Sie mich einfach an und nennen Sie mir die aktuellen Herausforderungen.

Ein klassischer Algorithmus würde versuchen, das eine „beste“ CRM zu finden häufig mit Test- und Vergleichsseiten als Ergebnis. Die tatsächlichen Bedürfnisse (Branche, Preisrahmen, technisches Know-how) bleiben unberücksichtigt. Außerdem bleibt unklar, ob das Suchergebnis gesponsert wurde oder wirklich unabhängige Informationen enthält.

Query Fan-Out erkennt, dass die Frage verschiedene Perspektiven zulässt, etwa:

- „Welche CRM-Systeme sind besonders günstig?“

- „Welche Systeme bieten viele Integrationen?“

- „Was empfehlen andere Startups?“

- „Welche Lösungen sind datenschutzkonform?“

Die KI verarbeitet diese Aspekte parallel und liefert bestenfalls eine differenzierte Auswahl mit Kontext: etwa drei Systeme, jeweils mit kurzer Begründung, warum sie für bestimmte Zielgruppen geeignet sind. Anhand der verlinkten Quellen lässt sich nachvollziehen, woher die Informationen stammen, ob diese Quellen seriös sind, muss überprüft werden.

Bedeutung für Content-Strategien

Query Fan-Out hat direkte Auswirkungen auf Content-Produktion und Sichtbarkeit. Statt einzelne Keywords zu adressieren, ist es entscheidend, Inhalte so zu strukturieren, dass sie auf verschiedene Subfragen eingehen können. Wer eine Seite über ein Produkt schreibt, sollte nicht nur das Produkt beschreiben, sondern auch verwandte Fragen mit abdecken:

- Anwendungsbereiche

- Unterschiede zu Alternativen

- rechtliche Aspekte

- Preismodelle

- technische Anforderungen

Denn: Nur Inhalte, die auch zu spezifischen Teilaspekten einer Frage passende Informationen liefern, können in den Antwortprozessen von KI-Systemen berücksichtigt werden.

Technischer Hintergrund

Query Fan-Out funktioniert in mehreren Schritten:

- Zerlegung: Die ursprüngliche Nutzeranfrage wird analysiert und in semantisch sinnvolle Untereinheiten zerlegt.

- Parallelisierung: Für jede dieser Subanfragen wird ein eigener Informationsabruf durchgeführt – aus Webdaten, proprietären Datenbanken oder internen Wissensmodellen.

- Aggregation: Die einzelnen Ergebnisse werden gewichtet, zusammengeführt und in kohärenter Form ausgegeben.

Dieser Prozess läuft im Millisekundenbereich ab und ist für Nutzerinnen und Nutzer nicht sichtbar. Sichtbar ist nur das Ergebnis: eine Antwort, die differenzierter und fundierter wirkt als klassische Suchergebnisse, aber nicht zwangsläufig korrekt sein muss.

In verschiedenen Studien wurden Fehlerquoten von 20 bis 40 Prozent in den Antworten von KI-Chatbots festgestellt. Für viele professionelle Zwecke ist das viel zu hoch und birgt Risiken für sog. KI-Slop oder Abmahnungen. Eine genaue Überprüfung der Antworten ist also zwingend erforderlich und das kann mehr Zeit in Anspruch nehmen als einen langen Text mit Hilfe von KI-Prompts zu erstellen.

Auswirkungen auf die Sichtbarkeit in KI-Antworten

Query Fan-Out führt dazu, dass Inhalte nicht mehr nur über einzelne Suchbegriffe gefunden werden, sondern über ihre Relevanz zu verschiedenen semantischen Facetten einer Anfrage. Das hat mehrere Folgen:

- Inhalte mit hoher thematischer Tiefe werden bevorzugt

- Faktentreue wird künftig immer wichtiger, die Inhalte müssen also auf Basis seriöser Quellen recherchiert sein.

- isolierte Seiten mit schmalem Fokus erscheinen seltener in KI-Antworten

- strukturierte Inhalte (z. B. durch Absätze, Tabellen, Zwischenüberschriften, FAQ) sind leichter extrahierbar

Wer künftig sichtbar bleiben will, muss verstehen, dass nicht mehr nur eine konkrete Frage beantwortet wird, sondern dass ein Suchsystem versucht, ein ganzes Themenfeld semantisch auszuleuchten. Entsprechend steigen die Ansprüche an die Content-Arbeit.

Sie brauchen Unterstützung bei der Recherche und Optimierung für Suchmaschinen und KI-Chatbots?

Sprechen Sie mich einfach an.

FAQ zu Query Fan-Out

Was unterscheidet Query Fan-Out von einer herkömmlichen Multi-Search?

Während eine Multi-Search gezielt mehrere manuell eingegebene Suchanfragen parallel ausführt, ist Query Fan-Out ein automatisierter Prozess. Die KI entscheidet selbst, wie viele und welche Subanfragen erzeugt werden, um ein umfassenderes Verständnis der ursprünglichen Frage zu erlangen. Ziel ist nicht die Darstellung verschiedener Ergebnisse, sondern die Generierung einer einzigen, integrierten Antwort.

Kommt Query Fan-Out nur bei Large Language Models (LLMs) zum Einsatz?

Primär ja. Das Verfahren ist eng mit der Architektur und dem Antwortverhalten großer Sprachmodelle verbunden, insbesondere bei Systemen mit Retrieval-Komponente.

Erhöht Query Fan-Out die Rechenlast von KI-Systemen?

Ja. Da mehrere Subanfragen gleichzeitig verarbeitet werden, steigt der Ressourcenbedarf. Das betrifft sowohl die Rechenzeit als auch den Speicherzugriff. Einige Anbieter setzen daher Optimierungen ein, z. B. heuristische Filter oder Priorisierung von Subanfragen, um die Rechenlast zu begrenzen.

Lässt sich Query Fan-Out im Verhalten eines KI-Chatbots erkennen?

In manchen Fällen ja. Wenn ein Modell sichtbar mehrere Perspektiven auf eine Frage liefert oder Zwischenschritte erwähnt („Ich habe dazu verschiedene Quellen berücksichtigt“), kann das ein Hinweis auf Query Fan-Out sein. Bei Google AI Mode wird die Anzahl paralleler Suchvorgänge teilweise sogar direkt angezeigt. In vielen Fällen läuft der Vorgang jedoch im Hintergrund und ist nicht transparent.

Führt Query Fan-Out immer zu besseren Antworten?

Nicht zwangsläufig. In Fällen mit klarer, enger Fragestellung kann Query Fan-Out überkomplexe oder übergeneralisierte Antworten erzeugen. Zudem hängt die Qualität stark davon ab, ob die generierten Subanfragen sinnvoll und die zugrunde liegenden Quellen vertrauenswürdig sind. Falsch gewichtete Informationen oder unscharfe Subfragen können die Genauigkeit sogar verschlechtern.

Kann man Inhalte gezielt für Query Fan-Out optimieren, ohne klassische SEO zu vernachlässigen?

Ja. Strukturierte Inhalte mit klarer semantischer Tiefe und breiter Themenabdeckung können sowohl für klassische Suchmaschinen als auch für LLM-basierte Systeme wirksam sein. Wichtig ist die zielgerichtete Abdeckung relevanter Subthemen innerhalb eines übergeordneten Kontexts, ergänzt durch eindeutige Formulierungen, maschinenlesbare Strukturen (z. B. mit Schema Markup) und kohärente Kontextbezüge.

Beeinflusst Query Fan-Out die Gewichtung von Quellen in der Antwortgenerierung?

Indirekt ja. Systeme, die Query Fan-Out einsetzen, bevorzugen Quellen, die mehrere Subaspekte eines Themas abdecken oder sich für unterschiedliche Subqueries eignen. Inhalte mit hoher semantischer Dichte und fachlicher Relevanz haben größere Chancen, in die Antwort einzugehen – auch wenn sie nicht das primäre Ziel der Hauptfrage sind.

Wie verändert Query Fan-Out die Rolle klassischer Rankings?

Da KI-Systeme Inhalte selektiv aus mehreren Quellen kombinieren, wird die Bedeutung einer einzigen Top-Position in den organischen Suchergebnissen relativiert. Sichtbarkeit ergibt sich zunehmend aus der Fähigkeit, auf Subfragen zu antworten – unabhängig davon, ob eine Seite für die Hauptfrage rankt. Die klassische SERP verliert dadurch an strategischer Relevanz.

Quellen:

“Google AI Mode’s Query Fan-Out Technique: What is it and How Does it Mean for SEO?” –– Aleyda Solis

„Large Language Models, scientific knowledge and factuality: A framework for their evaluation“ — Sciencedirect

https://www.sciencedirect.com/science/article/pii/S1532046424001424

„Factuality challenges in the era of large language models and fact‑checking“ — Nature Machine Intelligence

https://www.nature.com/articles/s42256-024-00881-z.pdf

„Factuality of Large Language Models: A Survey“ — arXiv.

https://arxiv.org/html/2402.02420v3

Sie möchten eine kurze Einschätzung zur SEO-Performance Ihrer Website?

Schreiben Sie mich einfach an und nennen Sie mir die aktuellen Herausforderungen.

„Long‑form factuality in large language models“ — DeepMind research publication.

https://deepmind.google/research/publications/85420/

Udo Raaf (Geschäftsführer)

Udo Raaf ist Publisher und SEO-Berater mit über 15 Jahren Erfahrung in der strategischen Suchmaschinenoptimierung für Unternehmen, Agenturen und gemeinnützige Organisationen.

Sie möchten wissen, welches Potenzial in Ihrer Website steckt?

Füllen Sie den nachfolgenden Fragebogen aus für eine unverbindliche Ersteinschätzung Ihres Projekts. Ich arbeite mit einem erstklassigen Netzwerk aus Web-Entwicklern, KI-Experten und Autoren zusammen, um maßgeschneiderte Lösungen anzubieten.